关键词:爬虫

这一节,我们讨论一下爬虫的一些注意事项

- 如何正确的对网页进行转码:

|

|

例子如上:对requests之后的response使用response.encoding='utf-8',然后再使用.text即可

一个好的爬虫专栏:

https://zhuanlan.zhihu.com/pachong

一译

JSONview插件chrome浏览器

我们使用 chrome 浏览器,点击域名栏左侧的安全或者是叹号,在里面将 javascript 选项选择阻止,如果重新加载之后网页没有变化,就说明不是使用 js 加载的,如果加载不出来,说明使用 js 加载的。

一般在站点的根目录下都会放置一个爬虫协议如:

http://www.baidu.com/robots.txt

里面的内容形式如下

>

解释下

>

>

>

- 关于使用 xpath

xpath 是 lxml 的一个获取HTML的一个东西,可以直接在检查中获取,因为 lxml 由 C 编写,所以速度要比BeautifulSoup快

- 关于 AJAX 加载的页面

有些网页,我们翻页之后,页面的URL不会发生改变,检查不是因为 js 加载的情况之后,一般在谷歌浏览器中右键检查然后选择network里面的all,这个时候我们换一下页码,然后看看里面的preview,就可以看出来了。

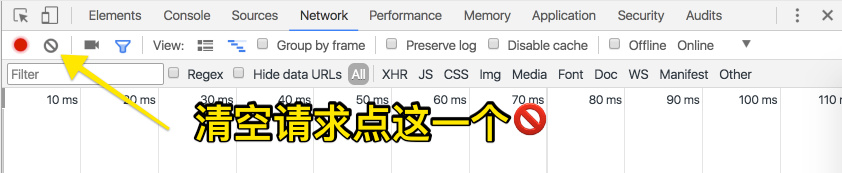

总结:一般,翻页之后,URL没有发生变化的一般为AJAX加载,我们要从XHR或者JS里面去寻找爬取的线索,一般要把所有的请求清空,然后点击下一页。

- JSONview插件chrome浏览器

可以在chrome 浏览器中使用这个插件,在异步加载 AJAX 过程中,我们就可以在开发者工具中,使用这个插件将 JSON 进行格式化输出

- 请求头headers 和响应头

在反爬虫做的很好的网站,必须加入好多请求头信息,爬虫才会默认我们是人类,而不是机器人

请求头:

>

响应头:

- 特殊的请求头和响应头信息——以知乎为例

知乎你登录后,浏览信息,他的request-header有好多不同之处

>

我把其中特别的几项(爬虫用于验证身份的几项列出来)

>

我们在爬虫的时候,需要将他们以字典的形式放在 header 字典里

- 大规模爬取与小规模的差很多